Breadcrumbs

- Digital Media Production

- Projekte

- Humankind – Interaktives Hörspiel

Humankind – Interaktives Hörspiel

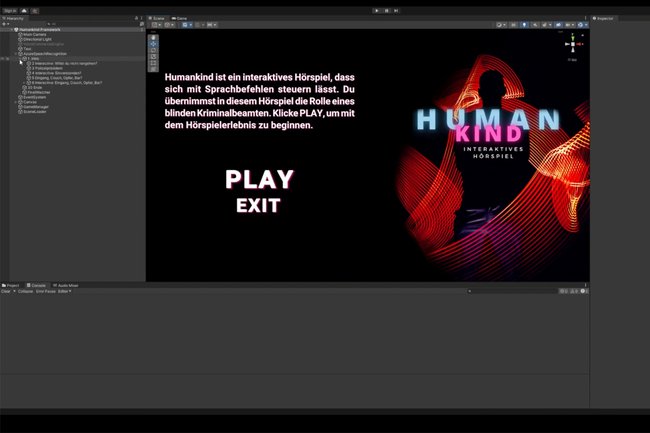

Humankind ist ein interaktives Hörspiel in Unity, das ausschließlich durch Sprachbefehle gesteuert wird und dessen Ablauf nicht linear, sondern interaktiv gestaltet ist.

Humankind ist ein interaktives Hörspiel, das in Unity umgesetzt ist. Die Applikation lässt sich ausschließlich mit Sprachbefehlen steuern und abspielen. Die Sprachsteuerung erfolgt dabei mit den Cognitive Services-Sprachdiensten von Microsoft Azure1. Mithilfe des Speech Software Development Kits2 (SDK) kann die Applikation mit hoher Genauigkeit Sprache in Text umwandeln und gesprochene Wörter erkennen.

Die interaktive Geschichte wird unter Einsatz der Spiel-Engine und Entwicklungsumgebung Unity3 in Storypoints (Gameobjects) strukturiert, die unter anderem die produzierten Audiodateien beinhalten.

"Nach einer Szene können Spielende zwischen mehreren Handlungsoptionen wählen. Entscheidend ist hier vor allem, dass die Abfragen dynamisch und ohne Pausen implementiert sind und nicht die Audioausgabe stoppen wie bei anderen kommerziell erhältlichen interaktiven Hörspielen wie z.B. Tag X4 und Tatort5, welche vom öffentlich-rechtlichen Rundfunk produziert wurden", sagt Thomas Klein.

Durch die Strukturierung in Unity werden nur vordefinierte Wörter während einer Abfrage erkannt und ermöglichen somit den Spielenden die Geschichte fortzusetzen. Der Ablauf des Hörspiels ist dadurch nicht linear, sondern interaktiv gestaltet.

Applikation in Unity | Copyright: Thomas Klein

Umsetzung

Die Produktion für das Hörspiel startete mit einer selbst erfundenen Geschichte, die anschließend in ein Manuskript überführt wurde. Das Manuskript wurde anschließend auf die Dramaturgie geprüft, damit bestimmte Spannungsbögen und Storyplots intensiviert werden konnten.

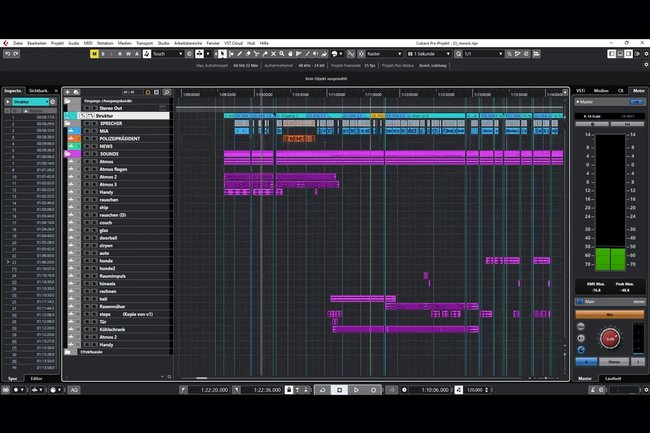

Im Produktionsmanuskript wurden dann Geräusche, O-Töne, Musik und Requisiten für die Spielhandlung (Telefon, Kamera und dergleichen benötigte Geräusche-Quellen) hinzugefügt. Die verschiedenen Rollen wurden danach auf die Sprecherinnen und Sprecher verteilt. "Das Manuskript sollte im Detail verstanden sein, damit Handlungsstränge, Spannungen und Betonungen sinngemäß richtig umgesetzt werden", so Klein. Nach der Fertigstellung der Sprachaufnahmen wurden alle Takes auf Fehler überprüft und anschließend auf die richtige Länge und Reihenfolge in Cubase6 arrangiert.

Im Audioschnittprogramm erfolgte nach dem Arrangement das Referenzieren mit Marker-Punkten, um den finalen Export zu erleichtern. In den nächsten Schritten wurden die Audiospuren normalisiert, stille Bereiche entfernt und Audiogruppen erstellt.

Nachdem alle Levels auf die ideale Aussteuerung überprüft waren, wurden die Sprachaufnahmen technisch mit Equalizer und Compressor bearbeitet. Im Anschluss wurden Kreativeffekte wie Hall, Pitch und ästhetische EQs verwendet, um das gewünschte Ergebnis zu erzielen und die Räumlichkeit der Audiospuren zu bewerkstelligen. Für das Metering wurde das K-System-Metering8 (K-12) von Bob Katz verwendet. Die Gesamt-Lautstärke des Programms beträgt -14 LUFS und -2 dBTP.

Audioproduktion in Cubase | Copyright: Thomas Klein